Hadoop集群启动方式及初体验

Hadoop 集群启动、初体验

1. 启动方式

要启动 Hadoop 集群,需要启动 HDFS 和 YARN 两个集群。

注意: 首次启动 HDFS 时,必须对其进行格式化操作。 本质上是一些清理和准备工作,因为此时的 HDFS 在物理上还是不存在的。

hdfs namenode–format

或者

hadoop namenode –format

1.1. 单节点逐个启动

在主节点上使用以下命令启动 HDFS NameNode:

hadoop-daemon.sh start namenode在每个从节点上使用以下命令启动 HDFS DataNode:

hadoop-daemon.sh start datanode

hadoop-daemons.sh start datanode 结合 slaves 文件启动所有 DataNode。

在主节点上使用以下命令启动 YARN ResourceManager:

yarn-daemon.sh start resourcemanager在每个从节点上使用以下命令启动 YARN nodemanager:

yarn-daemon.sh start nodemanager

yarn-daemons.sh start nodemanager 结合 slaves 启动所有 nodemanager。以上脚本位于$HADOOP_PREFIX/sbin/目录下。

如果想要停止某个节点上某个角色,只需要把命令中的 start 改为 stop 即可。

1.2. 脚本一键启动

如果配置了 etc/hadoop/slaves 和 ssh 免密登录,则可以使用程序脚本启动所有 Hadoop 两个集群的相关进程,在主节点所设定的机器上执行。

hdfs: $HADOOP_PREFIX/sbin/start-dfs.sh

yarn: $HADOOP_PREFIX/sbin/start-yarn.sh停止集群:

stop-dfs.sh、 stop-yarn.sh2. 集群 web-ui

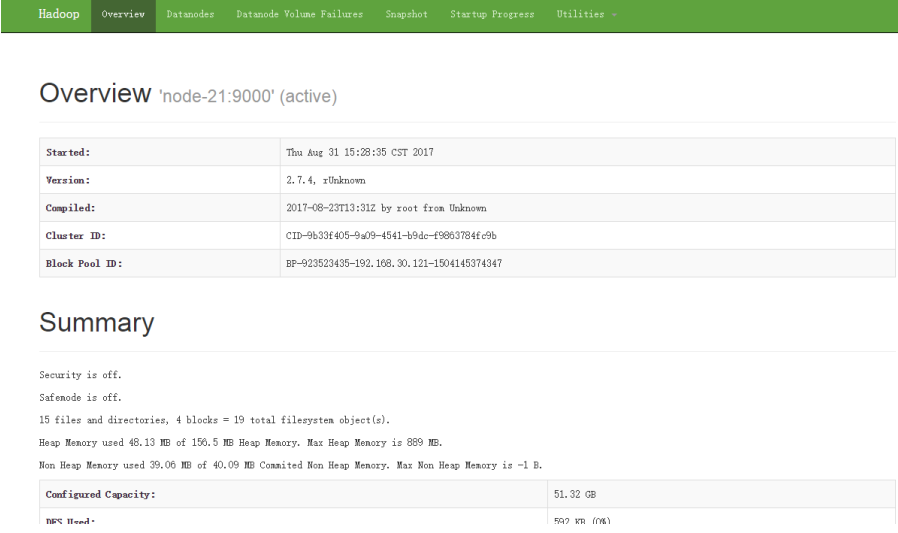

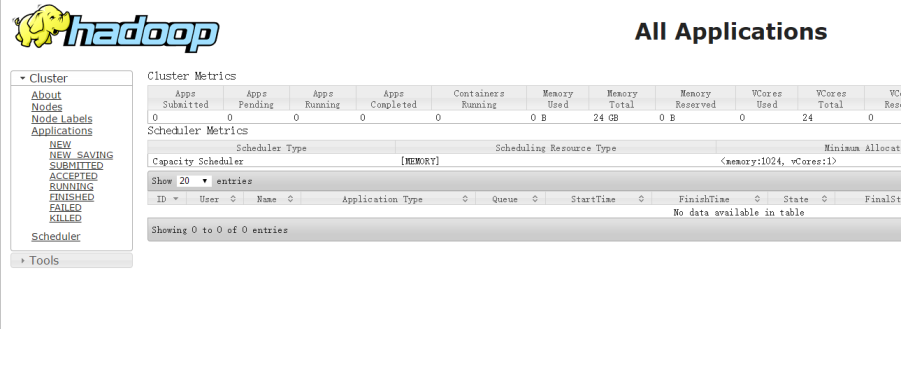

一旦 Hadoop 集群启动并运行, 可以通过 web-ui 进行集群查看,如下所述:

NameNode http://nn_host:port/ 默认 50070.

ResourceManager http://rm_host:port/ 默认 8088.

Hadoop 初体验

3.1. HDFS 使用

从 Linux 本地上传一个文本文件到 hdfs 的/test/input 目录下

hadoop fs -mkdir -p /wordcount/input

hadoop fs -put /root/somewords.txt /test/input3.2. 运行 mapreduce 程序

在 Hadoop 安装包的 hadoop-2.7.4/share/hadoop/mapreduce 下有官方自带的 mapreduce 程序。 我们可以使用如下的命令进行运行测试。

示例程序 jar:

hadoop-mapreduce-examples-2.7.4.jar计算圆周率:

hadoop jar hadoop-mapreduce-examples-2.7.4.jar pi 20 50关于圆周率的估算,感兴趣的可以查询资料 Monte Carlo 方法来计算 Pi 值。

友情提醒 : 如果电脑的cpu比较差的话,可以将后面的两个数字适当的改小一点,否则的话会报connect refused异常